Los pasados días 17 y 18 de noviembre asistí en Madrid al que se ha convertido en el segundo congreso sobre Big Data en Europa, BigData Spain, donde tuve la oportunidad de intercambiar conocimiento, experiencias y discutir oportunidades con más de 1200 personas.

Resumo en este post algunas de las tendencias y temas más calientes que fueron recurrentes durante todo el congreso.

Aprovechando que el próximo viernes 25 de noviembre en Biko celebramos nuestro 10º aniversario, voy a impartir un par de charlas, donde por supuesto os contaré cómo en Biko estamos ya aplicando técnicas Machine Learning y Big Data en algunos de los proyectos que realizamos, además de comentar muchos temas interesantes que vi en el congreso, que a continuación os resumo:

- A nivel general, el Big Data ya se ha convertido en el corazón de cualquier modelo de negocio que quiera tener éxito, y no solo en el mundo online, la aplicación de técnicas Big Data en el mundo de la industria está comenzando a implantarse con fuerza para quedarse.

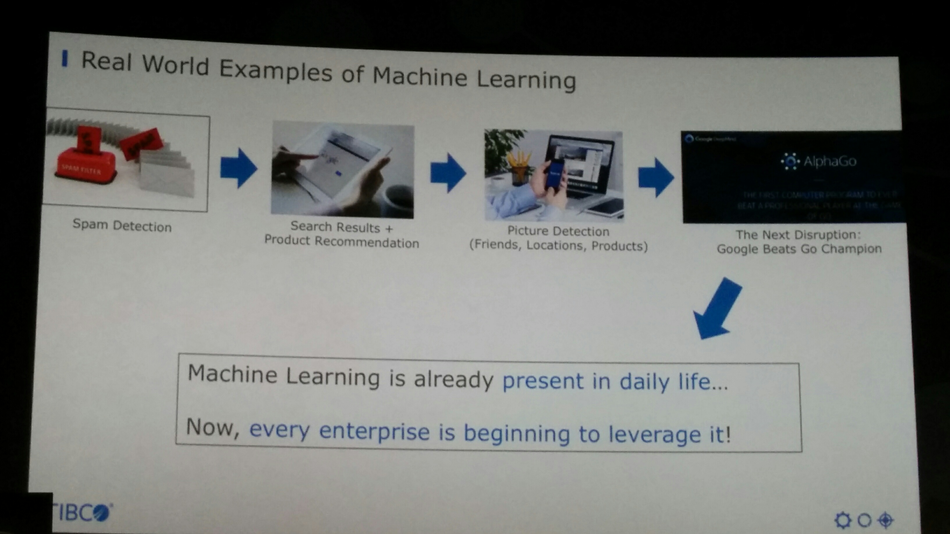

- Machine learning e Inteligencia artificial: Las tecnologías Big Data y de proceso masivo paralelo de datos ya han consolidado su madurez (Hadoop, R, Spark, Kafka, Hive, Cassandra, etc.) y están evolucionando muy rápidamente, permitiendo el desarrollo y explotación masivo de técnicas de inteligencia artificial y Machine Learning, al tiempo que servicios como Google Cloud Machine Learning o AWS Machine Learning en claro crecimiento están democratizando el acceso a la adopción de técnicas Machine Learning de forma masiva, al tiempo que se extiende la aplicación de técnicas complejas “Deep learning” gracias a la liberación de librerías como Tensor Flow.

No es casualidad que la gran mayoría de startups de éxito están basando su modelo de negocio y de generación de ingresos en estas técnicas Machine Learning.

- El profesional desarrollador de software “está de moda”: Los profesionales de desarrollo de software son cada vez más necesarios, valorados y cuidados por cualquier tipo de compañía, ya sean startups o grandes multinacionales. Las metodologías ágiles, la cultura DevOps y los modelos de desarrollo de código abierto abrazadas cada vez por más desarrolladores, están desplazando masivamente metodologías clásicas de gestión de proyectos de software como waterfall, y a modelos de “software factory” surgidos en la década pasada de los 2000. Bajo estos modelos de desarrollo, era muy frecuente que el desarrollador fuera considerado el profesional con menor aporte de valor… hoy esto está cambiando, innumerables presentaciones concluían con el clásico “Thanks by attending” seguido por un “We are hiring developers!!, please contact us at…”.

Por ejemplo, BBVA expuso cómo están desplegando pequeños equipos ágiles donde los desarrolladores trabajan junto a los responsables de unidades de negocio, entregando valor en iteraciones cortas, aligerando estructuras, acelerando entregas y ganando en calidad de software, con una adopción masiva de DevOps e infraestructuras cloud flexibles y escalables.

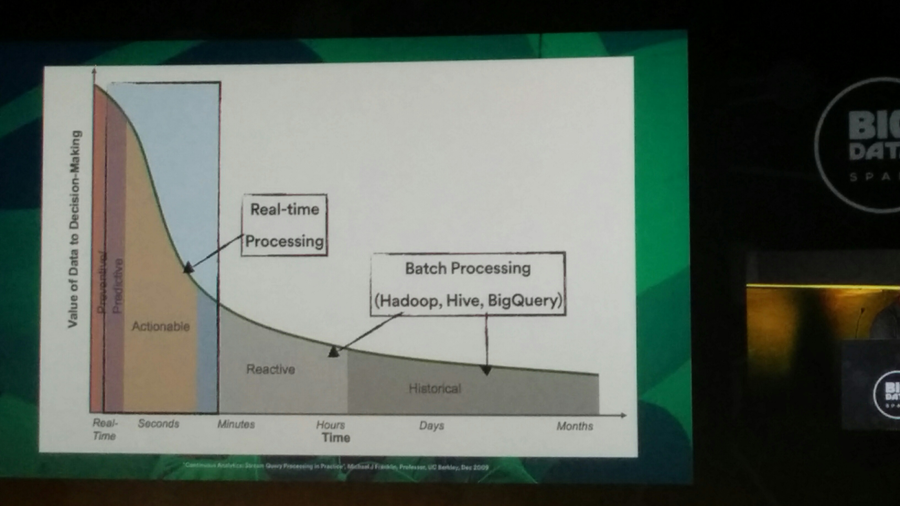

- Tiempo real: Prácticamente ya nadie habla de análisis de datos en modo “batch”, (Territorio Hadoop map-reduce) en el contexto Big Data, la maduración de plataformas como Spark y Apache Kafka están haciendo posible dar respuesta en tiempo real con técnicas Machine Learning en contextos donde la exigencia de clientes, proveedores y consumidores cada vez son más inmediatas en base a comportamientos y patrones, en resumen, hablamos ya de aplicaciones para explotar el “user behaviour” en tiempo real.

-

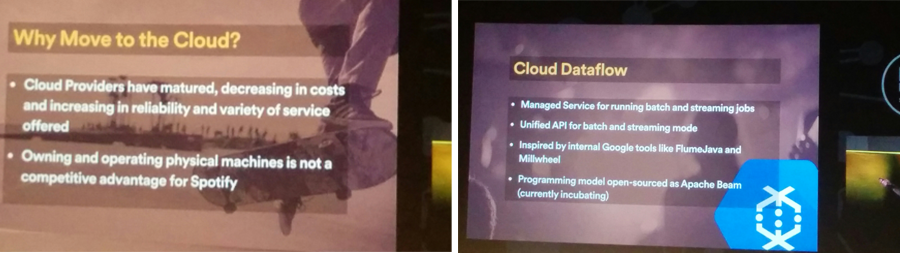

Migración del Big Data hacia modelos gestionados cloud: Existe una clara tendencia de migración de servicios y procesos de análisis de datos hacia proveedores cloud conforme los líderes (Amazon AWS, Google, Microsoft Azure y RedHat OpenShift) ofrecen servicios funcionales de análisis de datos y Machine Learning totalmente gestionados, y con precios cada vez más ajustados. Los servicios de análisis de datos y machine learning en cloud están desplazando modelos “on-premise” (Tanto con hardware propio como en plataformas cloud estándar) de infraestructura Big Data (Hadoop + Spark + Hive + Kafka) que requieren altos grados de gestión y mantenimiento de plataforma.

Resaltar el caso presentado por Spotify de como migraron de infraestructuras “on-premise” basadas en hardware dedicado a Google Cloud con servicios como BigQuery y BigTable.

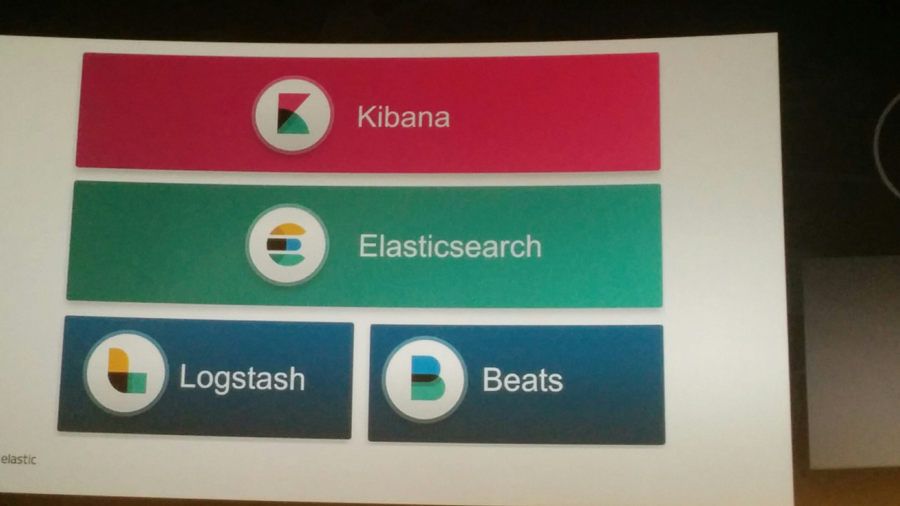

- Gestión de sistemas y software con modelos de gestión de datos: Se están extendiendo rápidamente plataformas de análisis de operación de software con herramientas analíticas Big Data especializadas como Elastic ELK (ElasticSearch, Logstash y Kibana) pudiendo operar en entornos on-premise o gestionados en plataformas cloud, donde una de sus características es la de poder extraer información adicional sobre cómo interactúan los usuarios con aplicativos online, por ejemplo en base a latencias, tiempos de respuesta, etc.

2 comentarios sobre “Big data Spain”