En mayo de este año, la revista Science se preguntaba si nos hemos forjado una imagen sobre la Inteligencia Artificial (IA) que no se corresponde con su rendimiento real, apuntando a la posibilidad de que podamos estar encaminándonos hacia un nuevo invierno de la IA.

Estas voces alertando de una nueva etapa árida son alimentadas también por las cada vez más habituales denuncias de sesgo sexista, racista, etc., en la IA, que no hacen sino sacar los colores a una tecnología cuyo desempeño parece quedar en cuestión.

¿En qué momento nos encontramos realmente? ¿Estamos más cerca de la ansiada singularidad de la IA o de un nuevo invierno? ¿El emperador está a punto de estrenar un nuevo traje mágico nunca antes visto o se pasea desnudo mientras algunos comienzan a señalarlo?

Desde Biko, de acuerdo con nuestro propósito de demostrar que la tecnología, si está hecha por y para las personas, impacta (e impactará) positivamente en la sociedad y en las organizaciones, hemos abordado estas preguntas con un experimento para comprobar la fiabilidad y el sesgo de algunas IAs actualmente.

Sobre ello, Pedro R. Montoro, nos realizó una entrevista para Radio 3. Pedro es Licenciado en Psicología por la Universidad de Murcia y Doctor en Psicología por la UNED. Trabaja como Profesor Titular en la Facultad de Psicología de la UNED y desempeña su actividad investigadora en los ámbitos de la Psicología Experimental y la Neurociencia Cognitiva. Interesado por la divulgación científica y la difusión del pensamiento crítico, en los últimos años ha impartido charlas y conferencias sobre la inteligencia artificial, sus desafíos y limitaciones.

Trascribimos sus certeras preguntas y la rica conversación que se generó en torno a ellas, como muestra de una reflexión colectiva, que consideramos necesaria, sobre la relación que estamos estableciendo con la inteligencia artificial.

P. Pedro R. Montoro: La inteligencia artificial está de moda. Estas dos palabras forman parte del lenguaje periodístico, tanto en la prensa generalista como en las conversaciones informales que se realizan en la sociedad. Incluso se utiliza en ocasiones como lenguaje publicitario cuando se dice que un audífono incorpora inteligencia artificial sin más detalle de las ventajas que eso proporciona; o cuando una agencia de trabajo temporal utiliza machine learning para seleccionar a los candidatos para sus ofertas de empleo.

Lo que parece indudable es que la imagen que se están forjando los ciudadanos de los avances de la IA a través de este tipo de noticias, de este tipo de reclamos publicitarios, es que los avances de la IA son imparables y que estamos muy cerca de alcanzar la inteligencia (artificial) genuina en ámbitos como el procesamiento del lenguaje, el reconocimiento de imágenes o la toma de decisiones. ¿Esto es una exageración o realmente estamos viviendo una revolución imparable en este campo?

R. Karlos: Sí que es cierto que ha habido una evolución. Muchos de los procesos tecnológicos tienen momentos épicos concretos que parecen muy revolucionarios. Pero considero que en realidad ahora mismo estamos en una especie de flujo, un stream. Hace tiempo que empezamos a hablar de conceptos como la nube, luego el big data, ahora la automatización… En ese flujo, en ese stream, hay una serie de momentos puntuales que generan la sensación de revolución. Pero no lo consideraría realmente una revolución. Los estudios alrededor de la inteligencia artificial empiezan en los años 60, lo que ocurre es que el mercado y, a veces, como dices, el mundo periodístico tienen la necesidad de utilizar la etiqueta “IA” recurrentemente. Es interesante revisar el proceso evolutivo tecnológico y poner atención en lo que está pasando en la IA, pero tanto como a la inteligencia artificial genuina, aún no hemos llegado.

P. Pedro: Y centrándonos en un ámbito concreto que vosotros conocéis muy bien y que habéis investigado y publicado recientemente artículos sobre el tema: ¿realmente la IA en el campo del reconocimiento de imágenes está en un momento de eficacia, fiabilidad y validez como la que nos vende el mercado? ¿O en cambio estamos confundiendo con magia lo que “no ni llega a ser un truco bien ejecutado”, utilizando esta sugerente metáfora que mencionáis en vuestro artículo?

R. Ujué: Lo que ocurre con la IA, y con el reconocimiento de imágenes que es el área que hemos abordado en nuestros últimos experimentos, es que, cuando se utiliza con un propósito muy concreto, su eficacia puede llegar a ser realmente sorprendente. Pero se nos olvida, a veces, que la IA es un sistema predictivo, y, por tanto, como predicción, cuenta con una precisión que es variable y posee margen de error.

No podemos presuponer que la IA va a ser igual de eficiente aplicada a una tarea muy muy concreta, como la de distinguir entre naranjas y manzanas, respecto a aplicarla para distinguir, por ejemplo, entre el universo de objetos existentes o describir a las personas del mundo. Pero si lo presuponemos, entonces desde luego estamos cerca de creer en la magia, cuando la realidad es que a veces el desempeño de la IA parece un truco mal ejecutado.

P. Pedro: Vosotros que conocéis bien cómo trabajan estos sistemas automáticos de reconocimiento de imágenes, ¿nos podríais comentar cuál es la tecnología que sustenta estos programas? ¿Son redes neuronales simuladas o son, en cambio, algoritmos simbólicos clásicos?

R. Karlos: Nosotros nos hemos centrado en las redes neuronales profundas, por ser el campo más fuerte y el que más curiosidad e inquietud nos generaba. Estas redes, conocidas como deep learning, simulan nuestro sistema neurológico, con sus neuronas, sus axones y demás. En el conjunto de resultados de los distintos trabajos académicos que se realizan para comprobar si estas redes funcionan, por ejemplo a la hora de clasificar imágenes, las redes profundas son mucho más eficaces que otras técnicas que se habían utilizado antes. Y es ahí donde han adquirido el peso fuerte en el sector. Por eso se oye tanto hablar de IA y redes neurales artificiales, estableciendo casi una relación directa entre ambas.

Lo que ocurre es que estos sistemas, estas piezas de software por decirlo de alguna manera, entrañan un realidad nueva o poco conocida hasta ahora. Durante toda la historia tecnológica siempre hemos tenido la capacidad de poder abrir el proceso tecnológico, mirar dentro de la caja. A lo que nos ha gustado mucho trastear, desmontar las cosas que teníamos a nuestro alrededor, nos encontramos con la sorpresa de que con las redes neuronales esto no ocurre. Ese conjunto de capas que conforman una red neuronal, que no dejan de ser piezas matemáticas que se van relacionando entre sí, es una caja negra. Por primera vez en la historia, una máquina tiene la capacidad de buscar el patrón estadístico que necesitamos pero no es posible mirar qué ocurre dentro de ella. Se trata de una máquina cuyo desempeño es más complejo y abstracto que nuestro propio mundo abstracto. Capa de abstracción más capa de abstracción y, finalmente, una caja negra. Y funciona, como decía antes Ujué, y en algunos casos incluso con resultados objetivamente mejores que los logrados previamente por otros algoritmos u otros sistemas tecnológicos, pero con ese gap, con ese problema: que dentro es difícil observar. Por tanto, si no puedo mirar dentro de la caja, ¿cómo sé que es correcto lo que sucede dentro?

«Por primera vez en la historia, una máquina tiene la capacidad de buscar el patrón estadístico que necesitamos pero no es posible mirar qué ocurre dentro de ella»

P. Pedro: ¡Que paradoja! Porque parece que vamos a tener que aplicar el mismo procedimiento de ingeniería inversa a la caja negra de una IA que el que utilizamos con seres humanos o con animales. En Psicología estamos continuamente intentando averiguar qué pasa dentro de la cabeza de la gente y aquí parece que está ocurriendo un poco lo mismo. De esas paradojas de ida y vuelta, ¿no?, entre el mundo tecnológico y el mundo natural.

Estamos mencionando vuestros trabajos, hemos aludido a ellos en varias ocasiones, y sería muy útil, porque además son muy interesantes, que nos describáis qué resultados habéis encontrado cuando habéis examinado la fiabilidad y validez de estos sistemas artificiales de reconocimiento de imágenes.

R. Ujué: Pues nuestra labor ha sido precisamente esa que mencionas. Hemos actuado como una especie de psicólogos de la IA. Como no se puede saber cómo están funcionando esos sistemas de reconocimiento de imágenes por dentro, porque son cajas negras y en su documentación se explica muy poco, la única manera que teníamos de conocer su funcionamiento era ponerlos a prueba.

Así, hemos analizado diferentes modelos de IA. Algunos eran productos comerciales como es el caso de Amazon Rekognition, y otros eran herramientas, modelos que se utilizan para el desarrollo de modelos propios, como Image2txt o MobilNet. Y hemos llegado a dos conclusiones principales.

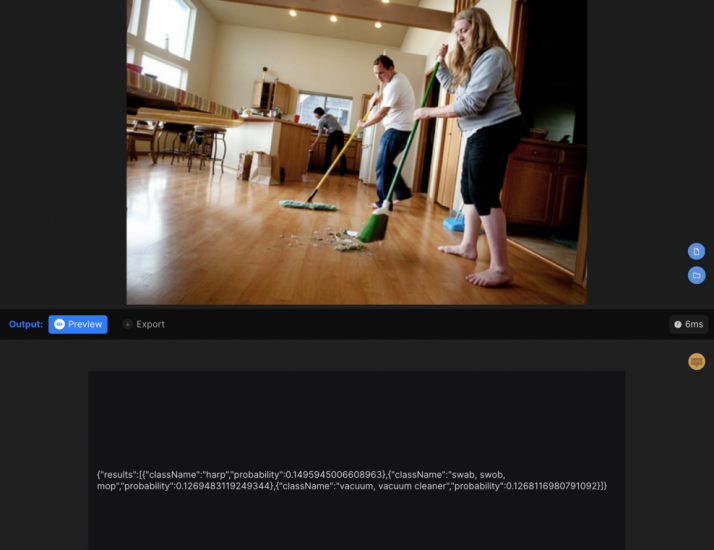

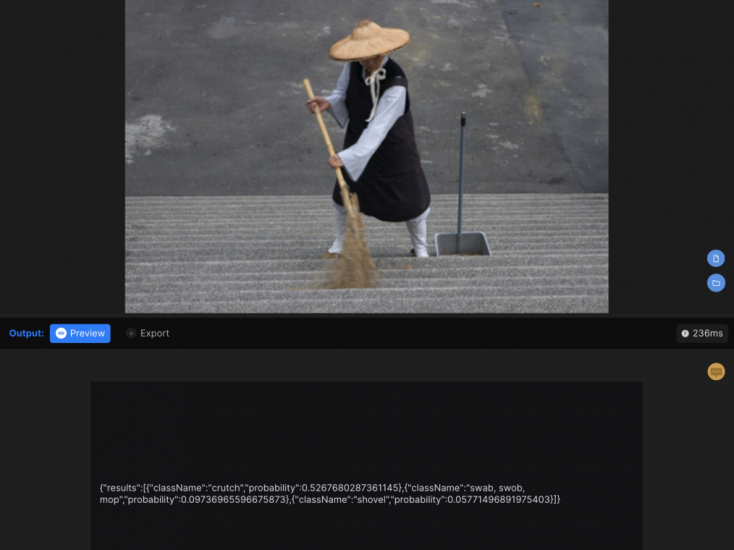

Por un lado, al testar estos modelos pasándoles fotografías de hombres y mujeres en contextos diferentes, hemos encontrado que la tecnología se utiliza en ocasiones con propósitos demasiado amplios, como esto que decía antes de clasificar el universo de objetos del mundo, muy lejos de tareas concretas como la de distinguir entre manzanas y naranjas. Y en estos casos su fiabilidad no es demasiado buena. Así, encontramos que, pasándole a la IA fotos de hombres y mujeres (con escobas, por ejemplo) en contextos de uso reales (barriendo), las confundían con otros objetos (muletas, arpas). Los motivos eran variados, pero podemos concluir que en general el desempeño no era bueno.

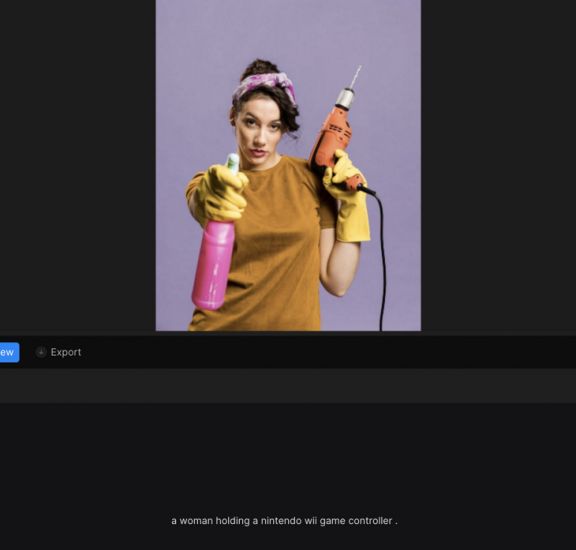

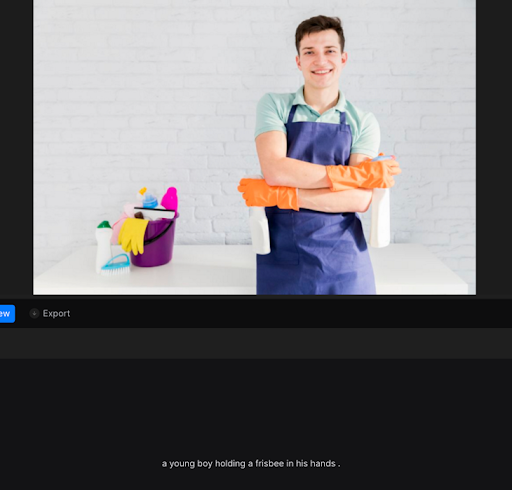

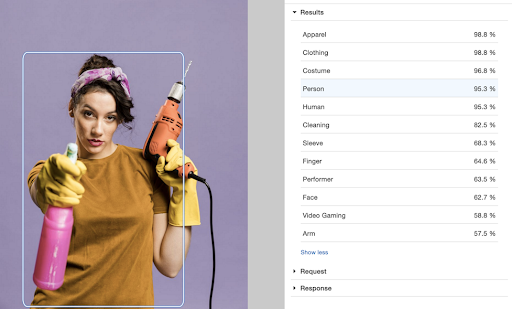

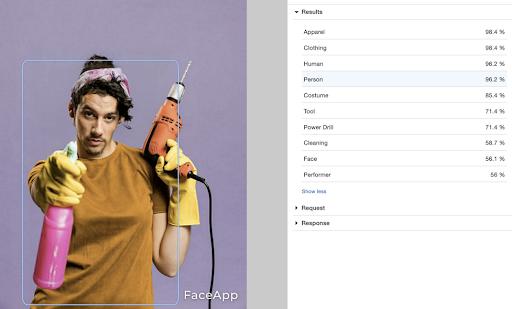

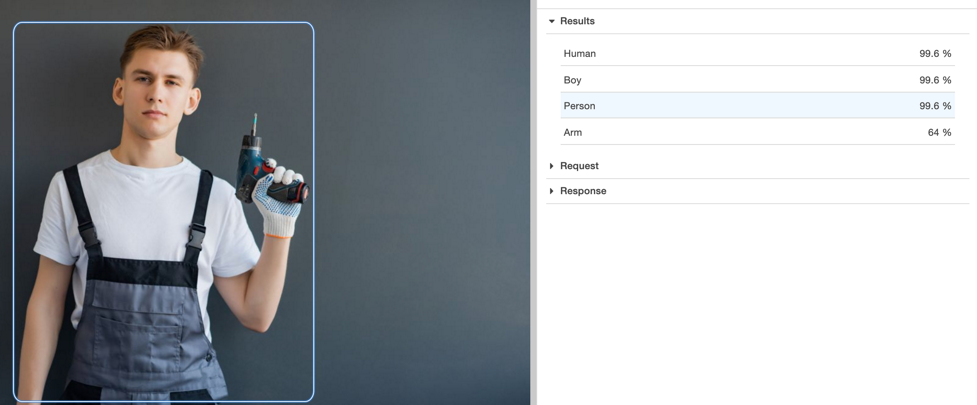

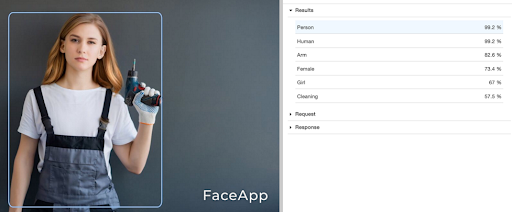

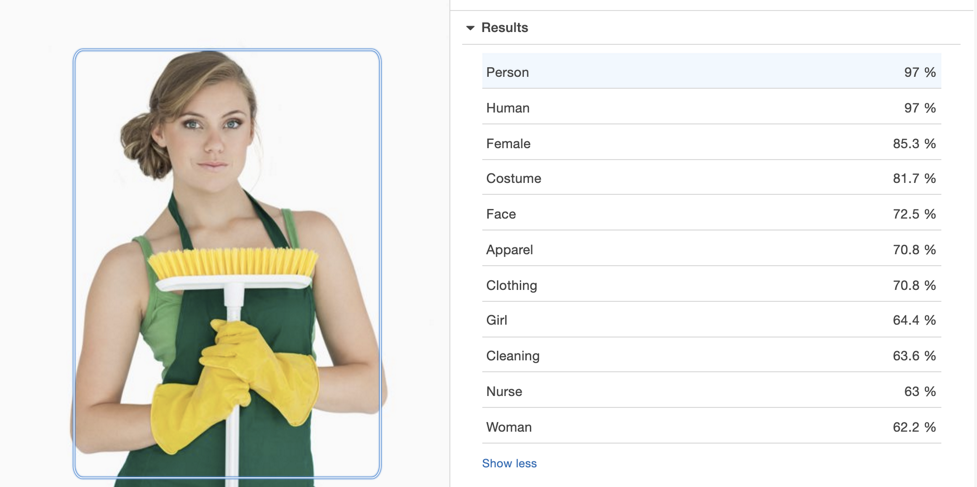

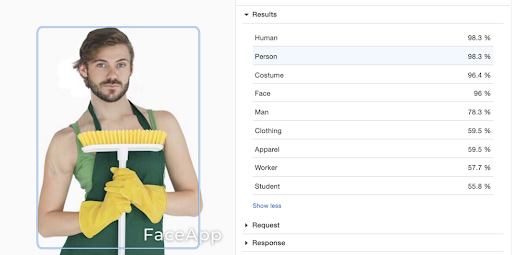

Por otro lado, encontramos que algunos de estos modelos sufren ciertos sesgos. En concreto, en estas IAs de reconocimiento de imágenes, de sesgo sexista. Con Amazon Rekognition, analizamos fotografías de hombres y mujeres que portaban objetos que históricamente se han entendido como estereotipados: escobas, taladros, martillos…Y a partir de una fotografía de un hombre o una mujer con un taladro o con una escoba, con FaceApp le cambiábamos el género aparente y pasábamos ambas fotografías por Amazon Rekognition para observar cómo la herramienta etiquetaba los elementos presentes en las imágenes.

Encontramos que, ante dos fotografías aparentemente iguales, donde lo único que cambiaba entre ellas era la apariencia de la persona (hombre, mujer), ya que el objeto, la posición, la iluminación, etc. eran las mismas, cuando aparecía una mujer el martillo se confundía con un secador de pelo, o un taladro se reconocía en la fotografía del hombre pero no en la de la mujer, o en una fotografía en la que ambos estaban con objetos de limpieza en la de la mujer la etiqueta era “enfermera” pero en la de hombre “trabajador” o “estudiante”…

En resumen, encontramos que el etiquetado, a pesar de que las fotografías solo cambiaban en la apariencia de género, no era similar en ambos casos.

Mientras que en la foto original no se detecta el objeto “taladro”, en la foto modificada por FaceApp sí.

En ninguna de las dos fotografías se detecta el taladro, pero a la modificada se le asocia la etiqueta “cleaning”

La actividad se detecta en la foto original, “cleaning”, pero no en la modificada. Además, las etiquetas sobre la posible profesión de la persona fotografiada cambian entre ambas imágenes: “Nurse” vs. “Worker” y“Student”